Palestras Científicas

Palestra Científica 1: Quarta-feira (19/10) das 13h30 às 14h30 – Sala: Ritz

HPC Cloud: Oportunidades para Elevarmos a Adoção de HPC

(Microsoft Azure)

Chegamos em um momento interessante na área de HPC. Até há pouco tempo atrás falávamos muito de MPI e OpenMP, mas ultimamente estamos falando muito de Big Data e Deep Learning. Muitas aplicações hoje em dia estão sendo movidas para plataformas de cloud e até os gerenciadores de recursos computacionais estão se adaptando para esse novo ambiente. É o momento de repensarmos várias questões ao redor de usabilidade em HPC, visto que devido às novas aplicações e plataformas computacionais, a nossa comunidade está aumentando muito. Que tal conversarmos sobre como chegamos até aqui e as grandes oportunidades de pesquisa e desenvolvimento em HPC Cloud?

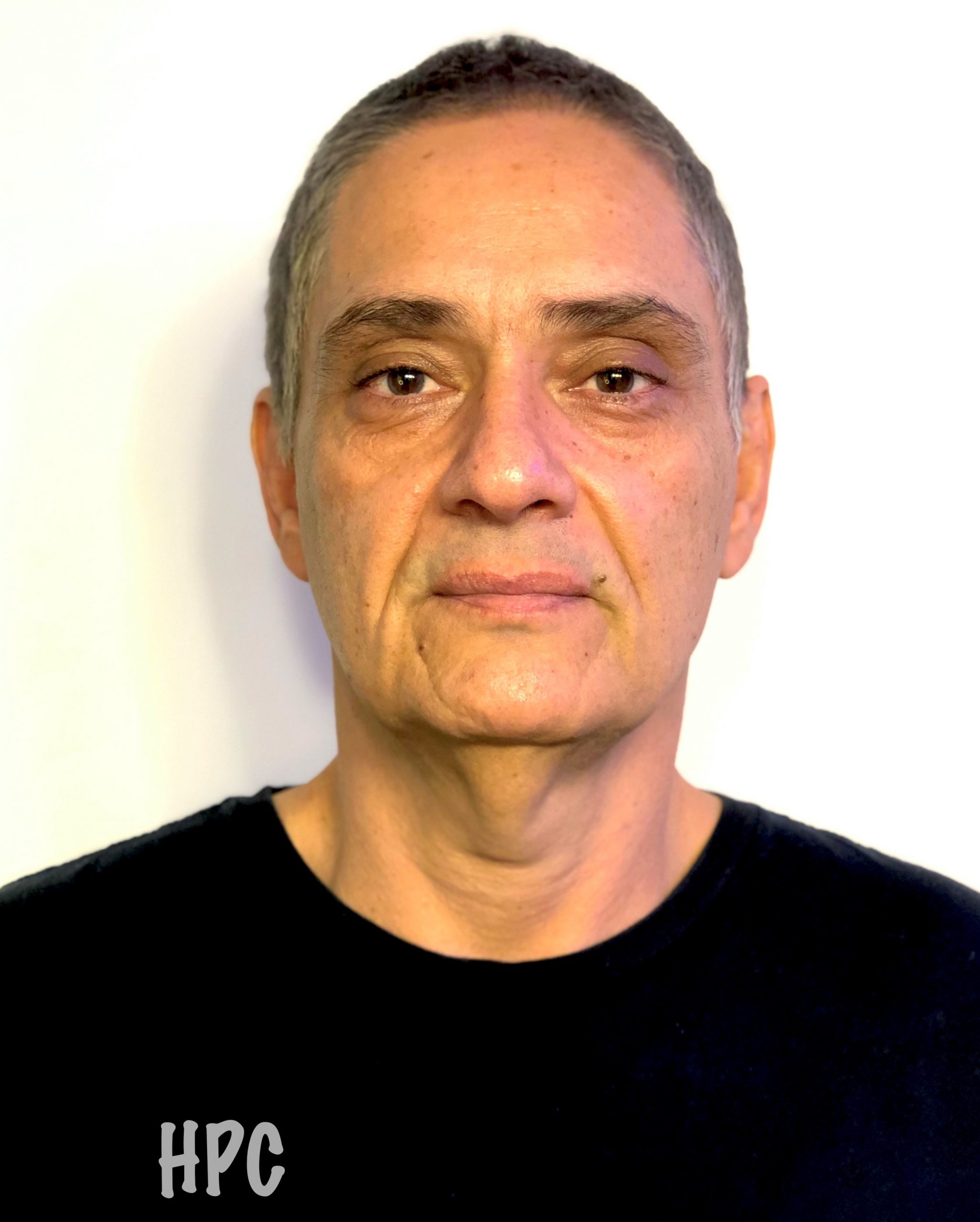

Biografia Resumida

Marco Netto possui mais de 20 anos de experiência na área de HPC onde seu interesse principal é gerenciamento de recursos para computação distribuída e como técnicas de gerenciamento impactam aplicações dos usuários. Marco publicou mais de 60 artigos científicos e 120 patentes (entre pendentes e concedidas) e é revisor ativo de diversas conferências internacionais, incluindo SC, e periódicos tais como IEEE Transactions on Parallel and Distributed Computing and Journal of Parallel, Distributed Computing e ACM Computing Surveys. Marco obteve sua graduação e mestrado em Ciência da Computação pela PUCRS e seu doutorado, também em Ciência da Computação, pela Universidade de Melbourne, Austrália, em 2010. Marco é membro sênior da IEEE.

Palestra Científica 2: Quinta-feira (20/10) das 13h30 às 14h30 – Sala: Ritz

Transforming Science and Engineering Research Through An Innovative High Performance AI+HPC Ecosystem at PSC

(Pittsburgh Supercomputing Center)

Artificial intelligence (AI) is transforming research through analysis of voluminous datasets and accelerating simulations by factors of up to a billion. Such acceleration far exceeds the speedups that were made possible through improvements in CPU process and design and other kinds of algorithmic advances. It sets the stage for a new era of discovery in which previously intractable challenges will become surmountable. To continue exploring the possibilities enabled, the research community requires a high-performance computational ecosystem that seamlessly and efficiently brings together scalable AI, general-purpose computing, and large-scale data management. The Pittsburgh Supercomputing Center (PSC) offers an innovative computational ecosystem to enable AI-enabled research, bringing together carefully designed systems and groundbreaking technologies to provide, at no cost, a uniquely capable ecosystem to the research community. The specialized ecosystem includes two major systems: Neocortex and Bridges-2. Neocortex embodies a revolutionary processor architecture to vastly shorten the time required for deep learning training, foster greater integration of artificial deep learning with scientific workflows, and accelerate graph analytics. Bridges-2 integrates additional scalable AI, high-performance computing (HPC), and high-performance parallel file systems for simulation, data pre- and post-processing, visualization, and Big Data as a Service. Neocortex and Bridges-2 are integrated to form a tightly coupled and highly flexible ecosystem for AI- and data-driven research. We will cover a detailed description of the AI+HPC ecosystem at PSC, share experiences in deploying and managing the systems, and highlight a set of representative scientific research projects that are leveraging this advanced cyberinfrastructure.

Biografia Resumida

Paola A. Buitrago is the founding Director of the Artificial Intelligence and Big Data group at the Pittsburgh Supercomputing Center (PSC) which is a joint effort of Carnegie Mellon University and the University of Pittsburgh in Pittsburgh, Pennsylvania, United States. The AI and Big Data group is focused on advancing and supporting the convergence of High-Performance Computing (HPC), Artificial Intelligence (AI) and Big Data. Paola is the principal investigator (PI) of NSF-funded ($12.5M) Neocortex, a specialized supercomputer that is designed to revolutionize national AI-enabled research by incorporating specialized AI-hardware (Cerebras CS-1). Paola is also PI for Open Compass, a platform for AI research on emerging hardware and software technologies, enabling the development of advanced algorithms and modeling approaches, and co-PI for Bridges-2 ($25M), a large heterogeneous and multipurpose supercomputer at PSC. Paola’s diverse background includes research in deep learning, large scale data, and workflow management for high energy physics experiments at the Fermi National Accelerator Laboratory. Paola’s academic background includes undergraduate studies in Chemical Engineering and Systems and Computing Engineering and graduate studies in Machine Learning at Carnegie Mellon University.

Palestra Científica 3: Sexta-feira (21/10) das 08h00 às 09h00 – Sala: Ritz

Otimização de Desempenho e Custos Financeiros na Execução de Aplicações de Alto Desempenho em Nuvens Computacionais

Recentemente, as nuvens computacionais têm sido apresentadas como uma alternativa de baixo custo para execução de aplicações de alto desempenho, oferecendo um conjunto de recursos virtualizados que podem ser provisionados e alocados dinamicamente com rapidez. No entanto, ainda existem vários desafios ao seu uso, como a seleção de máquinas virtuais (VMs) apropriadas e o escalonamento de tarefas da aplicação de alto desempenho nessas VMs, visando a redução de tempo de execução e custos financeiros, objetivos estes frequentemente conflitantes. Além disso, as VMs nos mercados mais baratos de nuvens comerciais estão sujeitas a revogações, e, para atender aos acordos de nível de serviço, a questão da tolerância a falhas deve ser tratada. Neste contexto, nesta palestra, apresentaremos uma visão geral sobre nuvens computacionais, e seu uso em Computação de Alto Desempenho (HPC). Também apresentaremos alguns problemas de gerenciamento de recursos em nuvens e algumas estratégias para resolvê-los, visando o uso eficiente dessas plataformas por aplicações de HPC.

Biografia Resumida

Drummond graduou-se Bacharel em Matemática – Informática pela Universidade do Estado do Rio de Janeiro em 1987, concluiu o mestrado em Engenharia de Sistemas e Computação pela Universidade Federal do Rio de Janeiro (UFRJ) em 1990, quando participou do desenvolvimento da equipe do primeiro computador paralelo da UFRJ, Brasil. Concluiu o Doutorado em Engenharia de Sistemas e Computação pela Universidade Federal do Rio de Janeiro em 1994, e o artigo principal de sua tese obteve o Prêmio de incentivo à pesquisa do Ministério da Ciência e Tecnologia e da Compaq Company, organizado pela Academia Brasileira das Ciências. Atualmente é Professora Titular da Universidade Federal Fluminense e seus atuais interesses de pesquisa são em computação de alto desempenho em nuvens. É Pesquisadora Nível 1 do CNPq e Cientista do Estado pela FAPERJ, com mais de 150 publicações em congressos e periódicos. É coordenadora da Comissão Especial de Arquitetura e Processamento de Alto Desempenho da Sociedade Brasileira de Computação. Foi Coordenadora de Programa das conferências SBAC PAD 2016 e 2020. Faz parte do Editorial Board do Journal Future Generation Computer Systems e tem participado de diversos comitês de programas de conferências internacionais prestigiosas, tais como EuroPar, ISC, Supercomputing, CCGRID, entre outras.

Palestras Industriais

Palestra Industrial 1: Quarta-feira (19/10) das 16h30 às 17h00 – Sala: Ritz

HPE Cray Frontier: O Primeiro Supercomputador Exascale do Mundo

A Hewlett Packard Enterprise (HPE) finalizou a entrega e implementação do Supercomputador Frontier HPE Cray EX para o Oak Ridge National Lab, um sistema que vai acelerar a inovação em ciência e tecnologia e manter a liderança dos Estados Unidos em Computação de Alto Desempenho e Inteligência Artificial. Este é atualmente o sistema número 1 do ranking do Top 500 (Junho/2022), site que lista os 500 supercomputadores mais poderosos do mundo. Nesta palestra, vamos fazer uma breve apresentação das principais característica deste sistema, assim como de sua arquitetura e suas aplicações.

Biografia Resumida

Mônica Costa é bacharel em Engenharia Eletrônica, com pós-graduação em Transformação Digital pela PUC-Rio, possui mais de 30 anos de experiência em Computação de Alto Desempenho, iniciando sua carreira na Control Data Corporation (CDC) na década de 1980 como Engenheira de Suporte dos mainframes CDC, na década de 1990 migrou para a Silicon Graphics (SGI) como Engenheira de Suporte/Vendas por onde permaneceu por 25 anos, hoje é Especialista em Computação de Alto Desempenho (HPC) e Inteligência Artificial na Hewlett Packard Enterprise, responsável pelas atividade de vendas para a América Latina.

Palestra Industrial 2: Quarta-feira (19/10) das 17h00 às 18h00 – Sala: Ritz

Migração de uma Aplicação de Exploração de Hidrocarbonetos em CUDA para SYCL/DPC++

A migração reversa no tempo (do inglês, Reverse Time Migration – RTM) utiliza o método de diferença finita para calcular aproximações numéricas para a equação de onda acústica. O método de diferença finita é um gargalo computacional para aplicações RTM e, portanto, precisa ser otimizado para obter redução de tempo computacional e eficiência na alocação de recursos computacionais para exploração de hidrocarbonetos. Nesta palestra será apresentada uma prova de conceito bem-sucedida, realizada pelo time de HPC do SENAI CIMATEC, utilizando uma API para migrar um código RTM em CUDA para SYCL/DPC++ usando a ferramenta Intel® DPC++ Compatibility. O código-fonte migrado é de fácil legibilidade e manutenção, pois unifica o fluxo de execução do algoritmo em somente uma estrutura. Além da experiência de migração, é possível explorar facilmente o gerenciamento de memória para obter melhor desempenho e intensidade aritmética. Após a migração para SYCL/DPC++, realizou-se uma reengenharia para obter maior paralelismo na execução das propagações de onda. Por fim, pretende-se utilizar o Intel® Advisor para mensurar o desempenho da aplicação e analisar possíveis melhorias.

Biografia Resumida

Tiago Oliveira é colaborador e pesquisador do Campus Integrado de Manufatura e Tecnologias do SENAI CIMATEC, atuando na liderança técnica de projetos de computação de alto desempenho, incluindo otimização e análise de desempenho e computação paralela heterogênea. Possui graduação em Ciência da Computação pela Universidade Estadual de Santa Cruz – UESC (2016). É mestrando em Ciência da Computação pela Universidade Federal da Bahia – UFBA. Trabalhou como professor substituto do Instituto de Computação da Universidade Federal da Bahia. Tem experiência nas áreas de Ciência da Computação com ênfase em Otimização Discreta utilizando métodos heurísticos aplicados a problemas de engenharia.

Palestra Industrial 3: Quinta-feira (20/10) das 11h30 às 12h00 – Sala: Ritz

Neptune Lenovo Liquid Cooling Techologies

Como a tecnologia de refrigeração a água está permitindo a performance extrema em HPC.

Biografia Resumida

Com 30 anos de experiência na área de TI no mercado latino-americano, Merino já trabalhou com soluções para as mais diversificadas verticais da indústria, como institutos de tempo e clima, empresas de energia, meio acadêmico e pesquisa, promovendo HPC/AI como ferramenta disruptiva para a extração de valor do dado em qualquer negócio.

Palestra Industrial 4: Quinta-feira (20/10) das 16h30 às 17h00 – Sala: Ritz

A (Longa) Jornada para Obter e Gerenciar um Projeto de HPC

Pesquisadores têm que recorrer às agências de fomento para conseguir financiamento para os seus projetos de pesquisa. Isso é ainda mais complicado quando envolve a compra de equipamentos de HPC. Nesta palestra vou contar um pouco da minha experiência em submeter, conseguir a aprovação e finalmente gerir um projeto de porte médio em HPC. Vamos falar sobre os desafios na submissão, quando nem sempre 4 aceites garantem a aprovação; os desafios na aprovação, quando se descobre que não dá para usar a máquina com GPUs do vizinho; e os desafios na gestão: não basta ter dinheiro para comprar. Nossa parceria com a Laniaq como fabricante e importadora de tecnologia foi essencial para vencer alguns desses desafios.

Biografia Resumida

Alfredo Goldman é Professor Associado no Instituto de Matemática e Estatística da Universidade de São Paulo (IME-USP). Possui doutorado em Sistemas da Informação no Instituto de Tecnologia de Grenoble (INPG), França, e mestrado e graduação em Matemática Aplicada na Universidade de São Paulo (USP). É editor associado do periódico Parallel Computing e membro de comitês de programa de congressos e periódicos internacionais como XP, IPDPS, IEEE NCA, ICPP JSSPP, SBAC, SBRC, SBES e SBQS. Foi co-coordenador de programa dos congressos IEEE-NCA 2014, SBAC-PAD 2014, WSCAD 2015, SEMISH 2022. Foi coordenador de trilha do EuroPar 2017, IEEE SCC 2020, EuroPar 2021 e CARLA 2022. Foi coordenador geral do IEEE-NCA 2017 e SBAC-PAD 2018. Seus principais interesses envolvem computação paralela e distribuída, escalonamento e métodos ágeis. Coordenou a Comissão Especial de Arquitetura de Computadores e Processamento de Alto Desempenho da Sociedade Brasileira de Computação (CEACPAD-SBC) entre 2017 e 2021. Atualmente integra o Conselho da Sociedade Brasileira de Computação (SBC) e é membro da ACM e IEEE-CS. É coordenador geral do projeto Temático FAPESP 2019/26702-8 com foco especial em HPC.

Palestra Industrial 5: Quinta-feira (20/10) das 17h00 às 18h00 – Sala: Ritz

Armazenamento – NAS , SAN, Cloud e agora?

NAS, DAS, SAN, Cloud, etc. Tantos termos e tantos tipos diferentes de soluções de armazenamento compartilhado em rede ou através da Internet. Nessa palestra, vamos desvendar um pouco a diferença de cada um deles, seus pontos fortes e fracos e como escolher a melhor tecnologia para sua estrutura.

Biografia Resumida

Guilherme Friol é especialista em computação com anos de experiência em ambientes computacionais de alta demanda, virtualização e HPC. Atua como consultor em arquitetura e otimização de sistemas de alto desempenho. Desenvolveu projetos relevantes junto a grandes instituições de pesquisa e notórios nomes da computação nacional em machine learning e redes neurais. Entre os projetos estão: Predição de Inibidores de Protease de Cisteína para Agentes Tripanocidas e Câncer (USP); Simulação de controle de veículo espacial e orientação de órbita (LAC-INPE); Pesquisa sobre plasmas astrofísicos e turbulências espaciais (ITA); Pesquisa em Astrofísica e física molecular (UNIVAP), entre outros.

Palestra Industrial 6: Sexta-feira (21/10) das 09h00 às 10h00 – Sala: Ritz

Acelere a Descoberta e a Inovação com a Computação de Alto Desempenho

Como extrair valor dos dados extraídos através de Iot, AI, Data Analytics e edge computing? Não importa se você está trabalhando para salvar vidas, fazer ciência, criar máquinas melhores, neutralizar os riscos financeiros ou antecipar o comportamento da natureza ou clientes. Com as soluções de computação de alto desempenho da Dell Technologies, você poderá impactar o sucesso da sua organização, pesquisa e moldar o mundo para um futuro melhor.

Biografia Resumida

Profissional com mais de 30 anos de experiência no mercado de Tecnologia de Informação, atua no ISG (Infrastructure Solutions Group) onde apoia os clientes na sua jornada de Transformação Digital através das soluções da Dell Technologies nas áreas de Compute, Storage e Networking.

Palestra Industrial 7: Sexta-feira (21/10) das 15h00 às 16h00 – Sala: Ritz

Os Rumos da Indústria de Armazenamento de Dados: do PC aos Projetos de Petabytes

Nesta palestra, apresentaremos um olhar sobre o avanço da tecnologia dos discos rígidos. Abordaremos as novas técnicas de gravação, densidades e capacidade, interfaces, conjuntos mecânicos com múltiplos atuadores e os avanços em desempenho. Também, discutiremos sobre a atual demanda crescente por capacidade de armazenamento massiva. Por fim, discutiremos sobre memória flash, SSD’s, novos form factors, interfaces, protocolos, computational storage e outras tendências.

Biografia Resumida

Osvaldo Junior é Especialista de Produtos na Seagate, gigante global da área de armazenamento de dados, há cinco anos. Também lidera um time de representantes Seagate atuando em campo no Brasil, Argentina, Chile, Peru, Colômbia e México. Atuou por dois anos e meio na Asus Computer ministrando treinamentos e 15 anos para a Intel, oito deles também como Especialista de Produtos/Instrutor. Estudou Administração de Empresas com ênfase em Negócios Internacionais na Fundação Santo André (SP).